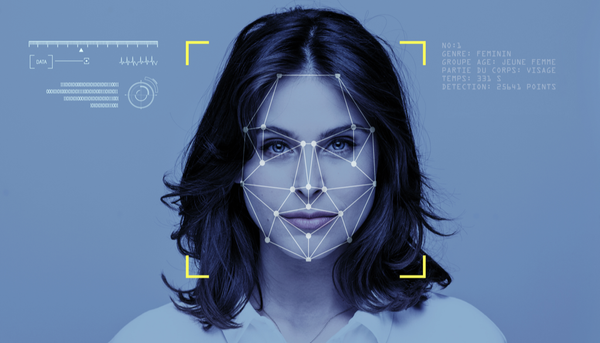

Les systèmes de reconnaissance des émotions peuvent être associés à des usages abusifs pouvant générer des biais ou de la discrimination – cela, sans compter l'absence de preuve quant au lien entre les émotions vécues et les expressions faciales. De ce fait, leur usage, à l'heure actuelle, devrait être limité et encadré: voilà la conclusion des travaux présentés par l'étudiante à la maîtrise en philosophie à l'Université Laval Alexandra Prégent, le 9 avril, à l'occasion de la Journée de la relève en intelligence et données présentée dans le cadre de la Semaine numériqc.

Quand on parle d'un système de reconnaissance des émotions (SRE), on parle de systèmes qui ont pour objectif de détecter, reconnaître ou identifier l'expression d'une émotion sur une personne. Cette reconnaissance consiste en général à l'analyse des traits du visage basé sur six grandes familles d'émotion qui encapsulent l'essentiel de la vie émotive chez l'humain: la joie, la tristesse, la peur, la colère, le dégoût, la surprise.

Mis en relation avec un visage neutre, il a été possible de corréler l'expression prototypique de certaines émotions à des mouvements faciaux particuliers. Une fois codés, les systèmes sont ainsi en mesure de reconnaître ces expressions et de les associer par la suite à l'une des six émotions de base.

Soupeser les nuisances et les bénéfices

Plusieurs usages sont associés à ces outils. Certains visent à répondre à des besoins précis – comme accompagner ceux ou celles qui ont des difficultés à reconnaître les émotions, notamment des personnes atteintes de troubles du spectre de l'autisme. «D'un côté, il est donc possible d'aider des gens dans leur quotidien, mais à l'inverse, l'usage de ces outils peut nuire gravement à d'autres individus ou à la société en général», affirme Alexandra Prégent. En effet, les mêmes outils, potentiellement bénéfiques, prennent une tangente problématique s'ils sont utilisés pour analyser la population pour des motifs de marketing, d'influence ou de surveillance. L'étudiante cite notamment le cas fort médiatisé de KAIROS qui, en 2019, vendait des SRE à des compagnies visant certains publics: restaurants, magasins, casinos. «Par exemple, on cherchait à estimer avec davantage de précision les chances que l'individu continue à jouer ou quitte la table.»

Au-delà de ce type d'usage abusif, Alexandra Prégent estime également que l'utilisation des SRE peut, dans certains cas, contribuer à la discrimination systématique de certains groupes dans la société.

À titre d'exemple, Alexandra Prégent cite les cas de Face++ et ApiFace, des systèmes de reconnaissance des émotions dont les capacités ont été testées par l'analyse de quelque 400 visages de joueurs de la National Basketball Association. Le résultat? Ils attribuaient aux joueurs à la peau noire des scores émotionnels plus négatifs en moyenne que ceux des joueurs à la peau blanche. «De ce fait, on peut facilement imaginer que des individus à la peau noire pourraient être désavantagés par la mise en application d'un tel système», souligne Alexandra Prégent.

Des technologies à améliorer

D'autant que ces technologies ne sont pas sans faille, car elles ne sont pas aptes à prendre en compte le contexte dans lequel l'émotion est exprimée. «Et pourtant! Le contexte est une partie intégrale de notre reconnaissance des émotions, en tant qu'humains. Nous reconnaissons un visage expressif, dans une situation particulière et dans un rapport social donné», poursuit Alexandra Prégent. «Un sourire peut cacher la colère, la frustration tout en étant reconnu comme de la joie par un SRE.»

Il est ainsi difficile de garantir que l'émotion identifiée par la technologie est réellement l'émotion exprimée par l'individu. «En fait, le grand problème pour démontrer l'efficacité des SRE, c'est qu'il n'est pas possible d'évaluer ce que les individus ressentent réellement au quotidien, et donc qu'il est ainsi difficile de prouver hors d'un doute raisonnable l'efficacité de cette technologie», explique-t-elle. On risque ainsi, selon l'étudiante, de se retrouver soit avec des résultats inutilisables, soit avec des résultats potentiellement erronés qui peuvent causer des torts à des individus.

Alexandra Prégent rappelle d'ailleurs qu'en raison de ces enjeux, le AI Now Institute avait, en 2019, appelé les législateurs à interdire l'utilisation des SRE «dans les contextes où des décisions importantes, qui ont un impact sur la vie des gens, sont prises».

L'étudiante estime ainsi que, d'un côté, les SRE utilisés comme outil d'aide à une seule personne représentent un intérêt pour la société et qu’ils devraient faire l'objet d'un encadrement légal approprié. Hors de cet usage toutefois, «il n'a pas été démontré que leur développement et leur usage serait fait dans l'intérêt de la justice sociale», évalue Alexandra Prégent.