20 mai 2025

Qui prend la décision la plus équitable: l’IA ou le fonctionnaire?

Un ouvrage récent s’intéresse aux biais algorithmiques dans les décisions prises par l’intelligence artificielle dans le secteur public et propose des solutions concrètes pour prévenir ces biais

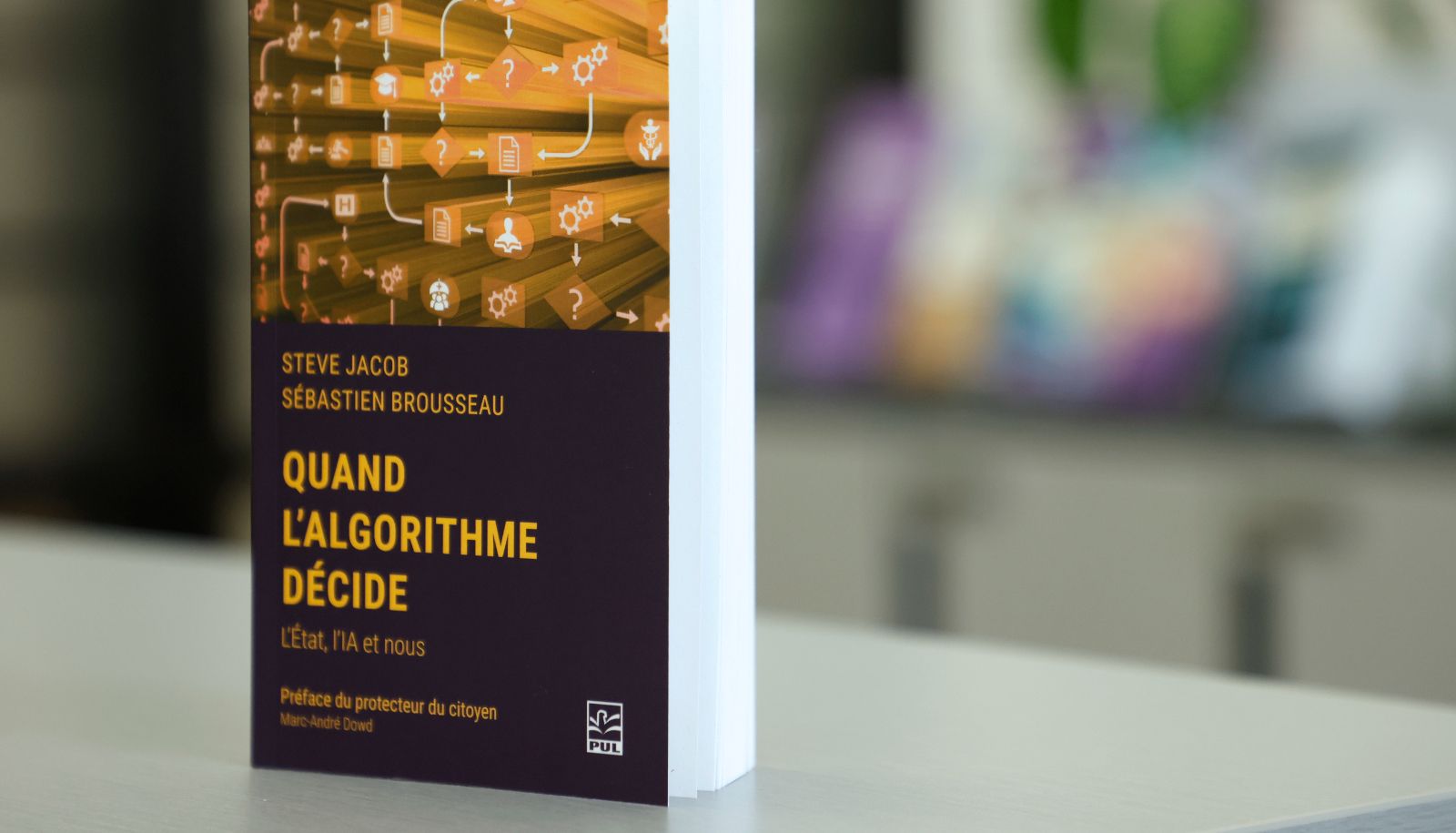

Publié aux Presses de l'Université Laval, dans la collection Éthique, IA et société – OBVIA, cet ouvrage démystifie différents biais algorithmiques pour éclairer et épauler les employées et employés de la fonction publique.

— Yan Doublet

Que ce soit pour l'attribution d'aides sociales, la détection de fraudes, la prédiction du décrochage scolaire ou la gestion des libérations conditionnelles, de plus en plus de décisions sont prises ou guidées par des algorithmes. L'intelligence artificielle (IA) a surtout été introduite dans la prestation des services publics pour des raisons d'efficacité et de réduction des coûts, mais plusieurs justifient également son utilisation par sa neutralité dans la prise de décisions. Mais cette neutralité est-elle bien réelle?

«En fait, la technologie crée une illusion de précision, d'infaillibilité et d'objectivité. Lorsque des organisations publiques choisissent de s'appuyer sur les analyses et les recommandations d'un algorithme, elles doivent connaître les nombreux biais qui peuvent survenir à diverses étapes du processus, d'autant plus que ces organisations rendent souvent des décisions qui peuvent peser lourd dans la vie d'un individu», explique Steve Jacob, professeur au Département de science politique et coauteur de l'ouvrage Quand l'algorithme décide: l'État, l'IA et nous.

Selon lui, le plus grand risque lié à l'intelligence artificielle est la méconnaissance de cette technologie – une méconnaissance qui peut mener jusqu'à de grands scandales politiques. Par exemple, en 2021, le gouvernement des Pays-Bas a été taxé de xénophobie et a dû démissionner parce que son administration fiscale avait utilisé un algorithme qui attribuait un risque de fraude plus élevé aux personnes immigrantes. «Et ce n'est pas le seul pays qui a dû faire face à un scandale algorithmique. Toutes les administrations sont à risque, mais le scandale peut être anticipé», remarque le professeur.

De concert avec le professionnel de recherche Sébastien Brousseau – l'autre coauteur de l'ouvrage –, Steve Jacob s'est donc lancé dans la quête des différents biais algorithmiques, occultés ou ignorés, afin de les mettre au jour: biais d'omission du gain, biais historique, biais d'étiquetage, biais de mémorisation, biais de transfert… Plus d'une vingtaine de ces biais sont ainsi répertoriés. Si pour un grand nombre de lectrices et lecteurs ces notions sont du jargon, il ne faut pas pour autant que l'ouvrage les rebute. Les biais y sont clairement expliqués, bien vulgarisés et accompagnés d'exemples concrets pour les illustrer.

Le professeur Steve Jacob (à gauche) et le professionnel de recherche Sébastien Brousseau (à droite), coauteurs du livre Quand l'algorithme décide: l'État, l'IA et nous

— Yan Doublet

Les deux auteurs ont le souci de présenter à quel moment du processus surgissent les divers biais. Il y a ceux qui arrivent à mi-parcours, notamment au moment de la collecte des données et de la validation du système. Toutefois, soulignent-ils, il ne faut pas oublier ceux qui arrivent très tôt dans le processus, dès la définition du problème, ni ceux qui arrivent très tard, dans le déploiement.

«Le message qu'on veut transmettre dans le livre, c'est qu'à chacune des étapes, il y a des biais potentiels. Trop souvent, les gens se concentrent sur une seule étape et supposent que s'ils y éliminent tous les biais, tout ira bien. Mais, non, il y a des réflexions à avoir durant tout le processus», affirme Steve Jacob, qui signale notamment que les organisations ont intérêt à bien réfléchir au problème qu'elles veulent résoudre avec l'IA. «Quand la réflexion en amont est mal faite, dit-il, il y a un grand risque de dérapage.» Un autre risque survient si une organisation choisit de se reposer sur ses lauriers après avoir créé son algorithme, car un emploi responsable de l'IA exige un travail continu.

— Steve Jacob, professeur au Département de science politique

Accompagner le secteur public dans son usage de l'IA

Comme l'explique Sébastien Brousseau, il y a quelque chose de paradoxal dans le sujet de l'ouvrage. «Les organisations publiques utilisent l'IA pour atteindre plus de transparence et diminuer les biais. De leur point de vue, si moins d'individus sont impliqués dans les décisions, celles-ci seront plus impartiales. Or, on doit l'admettre, les systèmes algorithmiques sont plutôt opaques quant à leur fonctionnement et ils reprennent les biais de la société. D'ailleurs, rappelons-le, des crises politiques ont découlé de décisions discriminatives générées par l'IA», déclare-t-il.

Ce paradoxe, ajoute-t-il, montre surtout que la machine n'est qu'un miroir de la société. Ainsi, s'intéresser aux biais algorithmiques, c'est avant tout s'intéresser aux biais humains. «Pour cette raison, le livre est, selon moi, fondamentalement axé sur l'humain», remarque-t-il.

— Sébastien Brousseau, professionnel de recherche à l'Observatoire international sur les impacts sociétaux de l'IA et du numérique

Est-ce dire que l'IA est condamnée à la même partialité que les êtres humains? Du moins, sa neutralité peut être améliorée. «Tout un chapitre porte sur des solutions adaptées à des problèmes spécifiques. Il y a donc des portes de sortie», affirme Sébastien Brousseau.

Avec cette dernière partie consacrée aux solutions concrètes, l'ouvrage semble répondre à un véritable besoin chez les agentes et agents de l'État. «Durant les derniers mois, j'ai donné beaucoup de conférences. Durant ces événements, certains ombudsmans m'ont avoué être démunis lorsqu'ils sont appelés à intervenir auprès d'un citoyen lésé par une décision administrative prise par l'IA», déclare Steve Jacob. Il se réjouit que le Protecteur du citoyen, qui signe la préface de l'ouvrage, reconnaisse l'utilité de la grille d'analyse et les solutions proposées dans l'ouvrage. «Pour un chercheur, c'est une mission accomplie d'arriver à transférer les connaissances vers les milieux de pratique», conclut le professeur Jacob.