— Getty Images/Evgeny Gromov

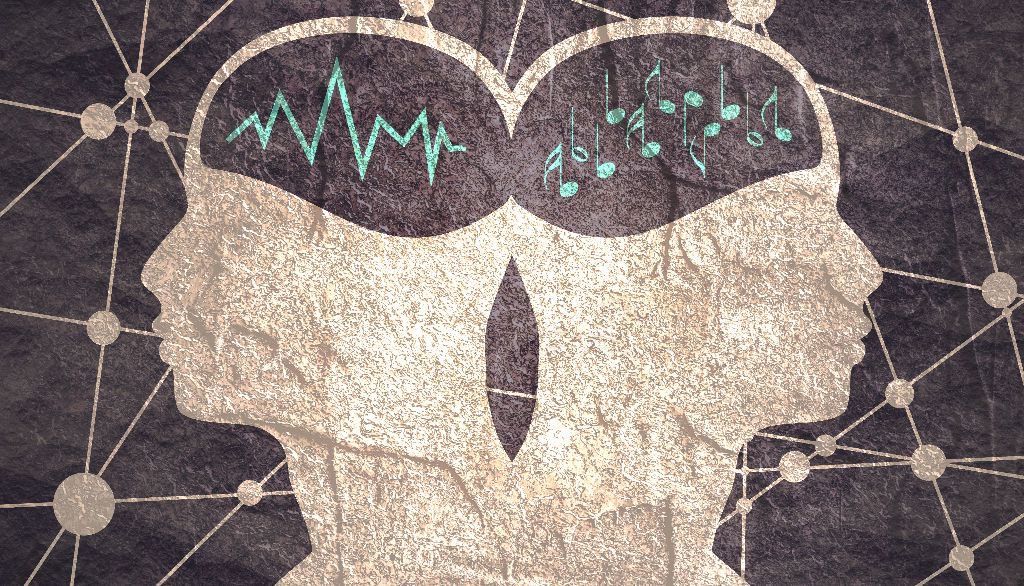

La parole et la musique sont deux formes de communication acoustique traitées différemment par le cerveau. En effet, plusieurs études réalisées au cours des dernières décennies ont montré que la parole est traitée préférentiellement dans l’hémisphère gauche, alors que le traitement d’une mélodie musicale se déroule surtout dans l’hémisphère droit. Une étude publiée aujourd’hui dans la revue Science par des chercheurs de l’Université Laval, de l’Université McGill et de l’Université Aix-Marseille apporte de nouveaux éléments qui aident à mieux comprendre les bases de cette asymétrie.

Le premier auteur de l’étude, Philippe Albouy, de l’École de psychologie et du Centre de recherche CERVO de l’Université Laval, rappelle que deux hypothèses ont été proposées pour expliquer la latéralisation du décodage des stimuli acoustiques. «Une vision "modulaire" propose que cette latéralisation est associée à l'existence de régions cérébrales spécifiquement dédiées à la perception de la parole, dans l'hémisphère gauche, et à la perception de la musique, dans l'hémisphère droit. L’autre hypothèse, que nous avons testée dans notre étude, est que des réseaux neuronaux distincts dans chaque hémisphère seraient sensibles à certaines propriétés acoutisques (fréquence, structure temporelle) de la parole ou de la musique.»

Pour tenter d’y voir plus clair, les chercheurs ont eu recours aux services d’un compositeur à qui ils ont demandé de créer 10 phrases et 10 mélodies musicales dont la combinaison a donné 100 courtes chansons. «Cette façon de faire nous permet d’étudier à la fois le décodage de la parole et de la mélodie en utilisant un seul signal qui contient les deux informations», souligne le professeur Albouy.

Les chercheurs ont ensuite demandé à une soprano d’interpréter a cappella chacune des versions. Voici l'une de ces chansons:

À l’aide de filtres, les chercheurs ont altéré les enregistrements de ces pièces pour en modifier la dimension temporelle ou la dimension spectrale, deux des nombreuses propriétés d’un signal sonore, précise Philippe Albouy. «Une dégradation temporelle consiste à brouiller les signaux sonores dans le temps. Plutôt que d’avoir un signal très précis temporellement comme lorsque l’on parle, on brouille le signal ce qui a pour conséquence de gommer la netteté des syllabes ou des phonèmes», explique-t-il. Voici la même chanson que ci-dessus après une dégradation temporelle:

Pour produire une dégradation spectrale des chansons, les chercheurs appliquent un filtre qui altère les fréquences des signaux acoustiques composant les sons. Revoici la même chanson après une dégradation spectrale:

Les chercheurs ont ensuite recruté 49 sujets à qui ils ont fait écouter les chansons a cappella, présentées par paires, en leur demandant de comparer soit les paroles, soit les mélodies.

Résultat? «Lorsque l’information temporelle est déformée, les participants ont du mal à reconnaître les paroles, mais pas les mélodies. À l’inverse, lorsque l’information spectrale est déformée, ils ont du mal à reconnaître les mélodies, mais pas les paroles. Cela montre que la reconnaissance et la perception des paroles et des mélodies dépendent de caractéristiques acoustiques différentes», résume le professeur Albouy.

Les chercheurs ont poussé leur investigation plus loin en réalisant un examen d’imagerie par résonance magnétique fonctionnelle du cerveau au moment où les participants procédaient à des comparaisons entre les chansons a cappella. Les images montrent que le traitement de la parole est observé principalement dans le cortex auditif gauche, et le traitement de la mélodie, principalement dans le cortex auditif droit.

— Philippe Albouy

Les chercheurs ont constaté que la dégradation de la dimension spectrale ne perturbait que l’activité du cortex auditif droit, et seulement pour le traitement de la mélodie. Pour sa part, la dégradation de la dimension temporelle ne perturbait que le cortex auditif gauche, et seulement pour le traitement de la parole. «La réponse différentielle dans chaque hémisphère dépend du type d’information acoustique perçu», constate le professeur Albouy.

Ces résultats suggèrent qu’il n’y aurait pas, à proprement parler, de région du cerveau spécialisée dans le traitement de la musique ou de la parole. «L’être humain a développé des systèmes neuronaux complémentaires qui permettent d'intégrer certaines propriétés acoustiques des stimuli auditifs dans chaque hémisphère, avance le chercheur. Ces unités de traitement sont donc sensibles à des propriétés différentes des signaux sonores et ceci explique la latéralisation observée lors de la perception de la parole et de la musique.»

Les autres signataires de l’étude sont Lucas Benjamin et Robert Zatorre, de l’Université McGill, et Benjamin Morillon, de l’Université Aix-Marseille.

Pour plus de détail sur l’étude, consulter la vidéo (en anglais) préparée par les chercheurs.